Date de publication : 21 septembre 2023, mise à jour le 30 septembre 2023. Durée de lecture : 11 minutes.

Ci-dessous la table des matières de l'article :

- Le webcrawler ChatGPT

- Les robots de collecte CCBot & GPTbot

- La syntaxe robots.txt, une arme de blocage rudimentaire

- CCBot, l’ogre

- Des fiefs d’abonnement ?

- Les 6 limites ou risques de l’IA générative

- Des norias de questions ...

Aujourd'hui, l'IA générative et les grands modèles de langage modifient radicalement et rapidement la mission des robots d'indexation. Les outils se retournent-ils contre les créateurs de contenu ? Si la publication d'informations en ligne implique de fournir gratuitement des données à un modèle d'IA qui vous fera concurrence pour attirer les utilisateurs, alors l’Internet risque de changer radicalement.

Le webcrawler ChatGPT

Lancé le 8 août 2023 par OpenAI, le web crawler GPTBot est dédié à « récupérer automatiquement des données depuis tout Internet ». Ce type de données, explique l’entreprise, doit servir à entraîner ses nouveaux modèles génératifs« comme GPT-4 et GPT-5 ».

Le lancement intervient alors que les plaintes pour infraction à la vie privée et au droit d'auteur se multiplient contre les différents LLM (large language model) déployés sur le marché. Le New-York Times pourrait d’ailleurs attaquer OpenAI car leurs juristes estiment que ChatGPT pourrait devenir un concurrent direct du journal : en répondant à des questions à partir des articles concernés et indexés, ChatGPT soustrait de fait le trafic des internautes qui se seraient autrement rendus sur le site du journal. Du coup, OpenAI supporte le protocole robots.txt ; sa documentation prévoit l'exclusion de GPTBot.

Les robots de collecte CCBot & GPTbot

Les robots d'exploration du web collectent désormais des informations en ligne pour alimenter des ensembles de données géants utilisés gratuitement par de riches entreprises technologiques pour développer des modèles d’IA.

CCBot alimente Common Crawl, l'un des plus grands ensembles de données d'IA.

GPTbot alimente OpenAI, l'entreprise à l'origine de ChatGPT et de GPT-4, le modèle d'IA le plus puissant à l'heure actuelle. En tant que chatbot développé par OpenAI, ChatGPT est construit sur la famille GPT-3 d’OpenAI. GPT-3, abréviation de Generative Pre-trained Transformer 3, est un modèle d’IA de pointe pour le traitement du langage, capable de générer des textes comme s’il s’agit d’un être humain. OpenAI a alimenté le modèle de 300 milliards de mots via 570 Go de texte brut, y compris des livres, des articles, Wikipedia, des posts sur Internet, etc. pour le faire fonctionner et l’améliorer.

Google se contente d'appeler ses données d'entraînement LLM « Infiniset », sans mentionner la provenance de la grande majorité des données. Bien que 12,5 % proviennent de C4, une version nettoyée de Common Crawl.

Si GPTbot est déjà bloqué par Amazon, Airbnb, Quora et des centaines d'autres sites web (cf. voir le dataset Google Spreadsheet de blocage IA des grands sites d’informations), CCBot de Common Crawl commence également à être bloqué.

La syntaxe robots.txt, une arme de blocage rudimentaire

La syntaxe robots.txt est aujourd’hui la seule option pour bloquer les robots d’indexation des outils d’IA. Selon Joost de Valk, de la société Yoast, cette syntaxe est rudimentaire. Créée il y a environ 30 ans, elle repose sur un accord tacite entre les moteurs mais n’a aucune valeur légale.

Eoghan Henn, de Rebelytics, a récemment rédigé un article complet intitulé « Indexed, though blocked by robots.txt » dans lequel il explique que la syntaxe robots.txt n’empêche nullement une URL d’être indexée même si celle-ci est bloquée ; les URLs déjà indexées avant d'être bloquées le resteront.

Les moteurs peuvent donc ignorer les instructions de blocage et siphonner tout de même les informations.

Le robot du moteur de recherche Brave ne prend d’ailleurs même pas la peine de divulguer le nom de son crawler, ce qui rend son blocage impossible.

Tout ce qui est en ligne peut être aspiré. Tout le monde ne peut pas de se payer un Datadome, solution performante qui protège les sites web des activités de scraping.

Jonathan Sampson, responsable des relations avec les développeurs chez Brave, a déclaré sur Reddit :

« Nous avons en effet notre propre crawler, qui construit activement notre propre index. Actuellement, l'index comprend plus de 8 milliards de pages, avec plus de 40 millions de pages parcourues chaque jour. Le crawler, qui n'a pas d'agent utilisateur unique, respecte le fichier robots.txt ».

Ils ne mentionnent même pas leur crawler dans leur documentation. Ainsi, si vous voulez empêcher Brave de crawler, d'indexer et finalement revendre votre contenu à des tiers, votre seule option pour le moment serait de bloquer tous les crawlers en espérant que Brave respecte la syntaxe robots.txt. D'ailleurs, les robots "AdsBot" et "AdSense" de Google, qui vérifient la qualité des annonces en lien avec les pages, ignorent le user-agent global (*) dans le fichier robots.txt. Le contrôle n'est donc pas du côté de l'éditeur.

Il se passe tellement de choses sous le capot des moteurs que les éditeurs ne sont pas protégés. Il est d’ailleurs possible de rédiger un prompt pour utiliser un agent utilisateur (user agent) personnalisé, ce qui confirme que la syntaxe robots.txt n’est pas une méthode pour protéger des données propriétaires.

Selon Joost de Valk, « ne rien faire (bloquer CCbot ou GPTbot) signifie que je suis d'accord pour que mon contenu se retrouve dans tous les modèles d'IA et de LLM du monde ; c’est tout simplement une erreur ».

Une meilleure version de robots.txt pourrait être créée, mais il serait très étonnant que les moteurs de recherche et les grands acteurs de l'IA s'en chargent eux-mêmes malgré la discussion publique initiée par Google le 6 juillet 2023 sur le contrôle des contenus indexés. Dans cet article, Danielle ROMAIN, VP chez Google, estime qu'il est temps pour les communautés du web et de l'IA d'explorer d'autres instructions techniques pour que les éditeurs de sites web disposent d’un choix et contrôle de leurs contenus en lien avec les usages émergents de l’IA. C'est d'ailleurs dans ce sens que l'entreprise de Mountain View autorise elle aussi le blocage de Bard et VertexAI.

User-agent: Google-ExtendedDisallow: /

Ce blocage complète celui du crawler ChatGPT :

User-agent: GPTBotDisallow: /

Selon Originality.ai, une société qui contrôle le contenu pour savoir s'il est généré par l'IA ou plagié, de plus en plus de sites web parmi les plus populaires utilisent robots.txt pour bloquer GPTBot, CCBot de Common Crawl et Anthropic (étude mise à jour - en anglais).

Seulement, ce blocage, basé sur la syntaxe robots.txt, n’a aucune base légale. Relève-t-il d'ailleurs d'un combat d'arrière-garde ?

Selon Jason Schultz, directeur de la Technology Law & Policy Clinic de l'université de New York, il est peu probable que le syntaxe robots.txt soit considérée comme une interdiction légale d'utiliser des données. Il s'agissait avant tout de signaler que l'on ne voulait pas que son site web soit indexé par les moteurs de recherche, et non de signaler que l'on ne voulait pas que son contenu soit utilisé pour l'apprentissage automatique et entraîner l’IA.

CCBot, l’ogre

Cette activité se poursuit depuis des années. OpenAI a révélé son premier modèle GPT en 2018, après l'avoir entraîné sur BookCorpus, un ensemble de données de milliers de livres indépendants ou autoédités. Common Crawl a démarré en 2008 et son jeu de données est devenu accessible au public en 2011 grâce au stockage dans le cloud fourni par AWS.

Bien que GPTBot soit désormais plus largement bloqué, Common Crawl représente une menace plus importante pour toute entreprise qui craint que ses données ne soient utilisées pour entraîner le modèle d'IA d'une autre société. Ce que Google a fait pour la recherche sur internet, Common Crawl le fait pour l’IA.

Common Crawl, via CCBot, détient ce qui est peut-être la plus grande base de données jamais collectée sur l'internet. Depuis 2011, il a exploré et sauvegardé les informations de 160 milliards de pages web, et ce n'est pas fini. En règle générale, il explore et enregistre environ 3 milliards de pages web par mois. L'énorme quantité de données qu'elle détient et continue de collecter est utilisée par certaines des plus grandes entreprises du monde pour créer des modèles essentiellement propriétaires. Certaines grandes entreprises technologiques ont cessé de divulguer l'origine de ces données.

Cependant, Common Crawl a été et continue d'être utilisé pour développer de nombreux modèles d'IA puissants. Il a aidé Google à créer Bard. Il a aidé Meta à former Llama. Il a aidé OpenAI à créer ChatGPT.

Common Crawl alimente également The Pile, qui héberge d'autres ensembles de données issus du travail d'autres robots d'exploration. Il a été largement utilisé dans le cadre de projets d'IA, notamment Llama et un projet LLM de Microsoft et Nvidia, appelé MT-NLG.

Des fiefs d’abonnement ?

Des auteurs, des artistes visuels, des comédiens (Sarah Silverman) et même des développeurs poursuivent en justice des sociétés comme OpenAI, Microsoft et Meta parce que leur travail original a été utilisé sans leur consentement pour former quelque chose dont ils ne tirent aucun avantage.

« Si vous copiez des millions d'œuvres, le montant de l'amende peut porter un coup fatal à votre entreprise », explique Daniel Gervais, codirecteur du programme de propriété intellectuelle à l'Université Vanderbilt, située dans l'État du Tennessee. Il renchérit : « À moins qu'elles ne négocient une solution, la question des droits d'auteur est une épée qui va planer au-dessus de la tête des entreprises d'intelligence artificielle pendant plusieurs années ».

L'avenir de toutes les œuvres créées en ligne pourrait bientôt ressembler à l'état actuel du streaming, avec des contenus enfermés dans des fiefs d'abonnement qui deviennent de plus en plus coûteux.

Les lieux communs risquent de se fermer avec donc de plus en plus de jardins clos auxquels les gens n'auront plus accès. Ce n'est pas un modèle de réussite pour l'avenir de la connaissance et de la créativité de l’humanité.

Les 6 limites ou risques de l’IA générative

Pourtant, les risques de l'AI génératives sont déjà identifiés.

Les livres blancs intitulés "Utiliser l'intelligence artificielle générative pour accélérer la création de contenu" d'Hubspot/Jasper et "La place de l'IA dans la génération de contenu SEO" de Yumens/Babbar en parlent. L'article AI could choke on its own exhaust as it fills the web, très intéressant, complète le panorama des risques, que nous avons synthétisé ci-dessous :

L’originalité

L’IA générative ne peut pas conduire ses propres recherches ni procéder à des analyses. Elle manque de substance, d’où la nécessité d’enrichir les réponses avec des éléments de fond et des travaux de recherche. Les contenus IA sont plus « standardisés » ; ils se différencient peu ou prou.

L'autre jour, j'assistais à une conférence et j'ai rencontré une femme nommée Erika. Elle m'a raconté que dans la classe de sa fille, trois élèves avaient échoué à un examen parce qu'ils avaient rendu un travail écrit par ChatGPT. L'enseignante l'a su car les trois dissertations partageaient des similitudes.

Anectode partagée par Neil Patel (23 septembre 2023)

Le vécu

L’IA générative imite le cerveau humain, mais elle ne peut pas simuler le vécu. Le ton du contenu peut donc être insipide, sans âme, sans opinion. L’humain doit ensuite injecter son expérience et son point de vue.

La qualité

L’IA générative couche des mots sur le papier dans un ordre logique. La qualité et le style d’écriture ne sont pas son affaire. Le temps libéré par l’IA doit donc être réinvesti dans les idées, le contrôle qualité et la stratégie éditoriale. Les réponses obsolètes et biaisées transforment le rédacteur en « rédacteur hybride » (germinations, corrections, reformulations, optimisations SEO). L’IA générative est intéressante pour gagner du temps, piocher des idées ou débloquer le syndrome de la page blanche.

La véracité

L’IA générative se base sur des contenus existants, récoltés par son robot d’indexation. Elle fournit des réponses qui doivent être systématiquement vérifiées.

Selon Yann Le Cun, directeur du laboratoire sur l’IA de Meta, l’IA générative est entraînée à prédire le mot suivant sans se soucier de la véracité de l’information : « les modèles actuels comme ChatGPT peuvent être une aide à l’écriture mais en aucun cas une source d’information ». Selon une étude de l’Université de Hong-Kong, seules 63% des affirmations générées par ChatGPT se sont révélées exactes.

Les erreurs ou « hallucinations » de ChatGPT sont donc fréquentes.

D’ailleurs, selon Getapp (groupe Gartner), 53% des utilisateurs français de ChatGPT ne vérifient pas soigneusement les réponses produites avant de s’en servir.

L’infobésité

Selon certains experts, le contenu des IA génératives pourraient représenter 90% de l’information disponible dans les années à venir. L'IA permet de créer des montagnes de nouveaux contenus tout en sapant la capacité à vérifier la fiabilité de ces contenus et en recyclant les préjugés, biais et erreurs des données qui ont servi à les entraîner. Les chercheurs appellent « effondrement du modèle », ce qui arrive aux modèles d'IA générative, comme les modèles GPT-3 et GPT-4 de l'OpenAI, lorsqu'ils sont entraînés à l'aide de données produites par d'autres IA plutôt que par des êtres humains.

La destruction des emplois

Selon une étude de Goldman Sachs, le chiffre d’emplois détruits avoisinerait les 300 millions (cf. L’intelligence artificielle va-t-elle détruire des emplois ?, avec Raja Chatila Roboticien, sur France Culture) Pour certains, le coup d’oeil à l’histoire montre que les innovations entraîne souvent la création de tâches insoupçonnées et citent le chiffre de l’économiste David Autor selon lequel 60% des actifs effectuent aujourd’hui des métiers qui n’existaient pas en 1940.

Pour d'autres, les emplois ne seront pas les seules victimes ; ce sont les tâches des emplois qui vont se transformer et les niveaux des rémunérations risquent de baisser. La société automatique va secouer très fortement.

Et pour le SEO ?

La publication de textes générés par l'IA comporte-t-elle de vrais risques en SEO ? Est-ce un jeu dangereux ?

Google utilise un ensemble de signaux pour repérer le contenu qui semble avoir été généré par l’IA, seulement, ces signaux ne sont pas connus. Google ne communique pas officiellement sur le sujet. Il met toutefois en garde : « Si vous utilisez l'automatisation, y compris la génération par IA, pour produire des contenus dans le but principal de manipuler les classements de recherche, cela constitue un non-respect de nos règles concernant le spam » précise la firme de Mountain View. Et en même temps, le CEO de Google, Sundar Pichai, a récemment affirmé "over time, this will just be how search works".

La rédaction humaine coûte certes plus chère que la génération de contenu via l’IA. Seulement, mettre en péril sa visibilité pour économiser relève-t-il de la faute de gestion ?

Est-ce que ChatGPT ou Bard pourront répondre à votre place aux questions suivantes :

- Est-ce que vos contenus proposent des « insights » originaux, des analyses et des articles en lien avec des travaux de recherche ? Il va falloir produire des contenus encore plus « expert » pour se différencier de la masse éditoriale générée par les IA.

- Si vous citez d’autres sources, y ajoutez-vous de la valeur « unique » ?

- Recommanderiez-vous fièrement vos contenus à vos pairs ?

Les outils (Jasper, AIquill, Quillbot, CopyAI, Hypotenuse AI, Byword, Simplified) vous répondront probablement par l'affirmative.

Pour d'autres ...

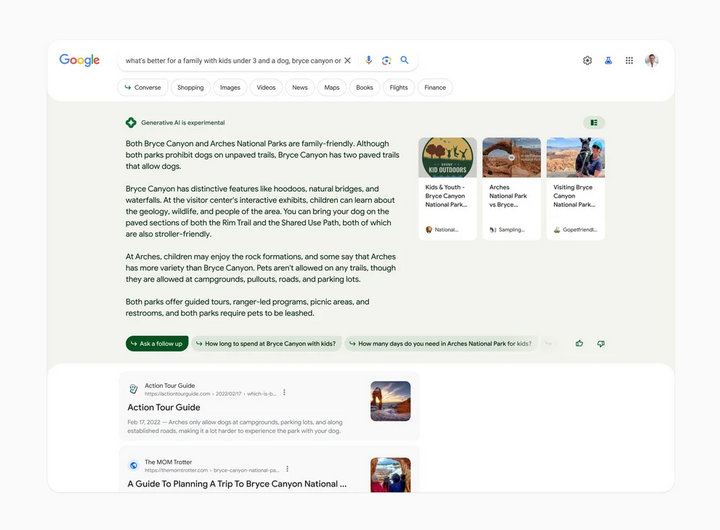

Ce qui compte, ce n’est pas le trafic mais la persuasion. Bloquer les robots AI empêcheront les « marques » d’être visibles sur les sources de connaissances de demain. Les chatbots conversationnels sont les moteurs de recherches de demain.

Commentaires LinkedIn : Paolo Margari / Julia Walsh qui évoque le concept de « Search Chat Optimization »

Des norias de questions ...

Tout cela sous-tend une multitude de questions :

- Les moteurs vivent-ils leurs derniers jours ? Selon certains, l’ère des moteurs touche à sa fin alors que l’âge des assistants IA commence maintenant. Selon Neil Patel/AnswerThePublic, avec 89,3 milliards de visites chaque mois (faut-il en rêver ?), Google a plus à perdre que Bing. Si le nouveau Bing, avec l’assistant conversationnel de ChatGPT, n’est pas encore un « game changer », il a tout de même gagné 10% d’utilisateurs à 98 millions d’utilisateurs entre février et juin 2023, loin derrière les 1,12 milliard d’utilisateurs de Google. La part de marché progresse surtout sur mobile avec le navigateur Edge.

- Le Search basé sur les mots-clés va-t-il disparaître dans 2 à 3 ans ? Nous le voyons déjà sur Google Ads. Feu les enchères manuelles (?). Les enchères intelligentes et automatisées (smart bidding) sont l'avenir ... La campagne automatisée & unifiée Performance Max, avec son algorithme « surpuissant », va faire le travail de trouver les clients. Le « où » n’est plus l’affaire des annonceurs. Google dispose du contexte, il n'a plus besoin des mots-clés. L’omnicanalité de Google est une black box truquée, tournée vers des audiences dont le prix des enchères est artificiellement modifié (cf. récentes déclarations de Jerry DISCHLER, VP des produits publicitaires de Google).

- Le Search Chat Optimization va-t-elle se substituer à la Search Engine Optimization ? Le Journal du Net cite une potentielle baisse de trafic organique de 18 à 64 % avec Google SGE. ChatGPT reçoit déjà 1,4 milliard de visites chaque mois, ce qui mécaniquement transfère certains usages depuis Google. SGE est-elle l'acmé du zéro clic dans la mesure où Google apportera des réponses plus complètes et parfois suffisantes pour des requêtes de plus en plus étendues et de plus en plus mobiles ?

- Les données structurées (format JSON-LD), cette surcouche de données qui allège le travail d'indexation, vont-elles devenir plus cruciales ? Derrière, cela fait référence à la valorisation du Knowledge Graph et du Shopping Graph.

- Le calendrier du DMA (Digital Market Act) va-t-il être bousculé ? La Commission européenne, si prompte à défendre l'état de droit, a ré-autorisé le transfert des données vers les États-Unis avec le Data Privacy Framework le 10 juillet 2023. À l'instar de ce "Safe Harbor v3", selon Patrick Blum, délégué général de l’AFCDP, l’association qui réunit les professionnels de la protection des données personnelles en France, le DMA va-t-il être atomisé ? Pour rappel, Google dispose d'un position dominante avec son Pack local, avec des négociations qui doivent débuter en mars 2024 pour le supprimer. La visibilité de Google My Business devrait être impactée à hauteur de 90 à 95%. Seulement, avec l'arrivée de Google SGE, l'UX des SERPs (avec le Pack local) change complètement.

Comme tout cela donne le vertige, à l'heure où l'humanité n'a pas besoin d'une nouvelle bombe environnementale, nous terminerons par cette sentence :

L’avenir appartient à des couples mi-hommes, mi-machines, baptisés « centaures » par certains experts de l’IA. À court et moyen terme, cela va secouer.

Source : Les Échos - L’IA, bientôt une collègue comme une autre (25 mai 2023)

Dans ce monde automatisé de "centaures", si nous utilisons tous exactement les mêmes technologies d'IA génératives et les mêmes stratégies d’enchères sur Google Ads, les imitateurs auront très certainement du mal à s'imposer. Où seront les réponses ? Dans les prompts ?

Revenons donc à ce que nous sommes ... Les tâches cognitives (résolution des problèmes, créativité), qui cristallisent le savoir-faire, dépendent d'un processus de lente maturation de mémorisation et de compréhension, ce qui se nomme "savoir". Ces tâches exigent des connaissances solides, disponibles et flexibles. Le cerveau à besoin d'encoder des informations depuis la mémoire de travail vers la mémoire de long terme puis de créer des accroches multiples pour les récupérer dans le sens inverse. Le manque d'accroches nous fait "faussement" oublier. Il nous faudra plus que jamais ces savoirs et savoir-faire pour se différencier (offre, service client, positionnement, prix, options de marché, pages de destination, messages et creatives) prendre du recul et éviter d'être noyé par l'information.

Sources (plus celles dans l'article)

- https://www.businessinsider.com/ai-killing-web-grand-bargain-2023-8

- https://blog.google/technology/ai/ai-web-publisher-controls-sign-up/

- https://stackdiary.com/brave-selling-copyrighted-data-for-ai-training/

- https://www.reuters.com/legal/sarah-silverman-sues-meta-openai-copyright-infringement-2023-07-09/

- https://www.rebelytics.com/fixing-indexed-though-blocked-by-robots-txt-case-study/

- https://originality.ai/blog/study-websites-blocking-gptbot

- https://www.slate.fr/story/251950/new-york-times-menace-poursuivre-openai-chatgpt-justice-droits-auteur

- Pourquoi ChatGPT est une bombe environnementale

- Crédits Photo Medium : Qui bloque GPTbot d’OpenAI et CCBot en France le 8 septembre ?